Opportunité

Depuis 1972, l’Administration de Pilotage des Laurentides (APL) a la charge de l’administration et de la livraison de services de pilotage maritime sur le fleuve St Laurent et la rivière Saguenay au Québec. Chaque année, ce sont environ près de 8000 navires, en provenance des 4 coins du monde, qui transitent par ces eaux. Soit environ 22 000 affectations annuelles que l’APL gère à travers son centre de répartition.

L’APL souhaite aller plus loin dans l’exploitation de ses données mais reste freinée par de multiples problématiques comme l’impossibilité d’obtenir une vue d’ensemble de ses données, des limitations dans leur gestion ou encore la dépendance à un fournisseur pour la production ses rapports d’analyse.

Elle est décidée à se doter des meilleurs outils analytiques, prévisionnels et décisionnels afin d’être en mesure d’améliorer grandement ses capacités d’analyse ad-hoc en lien avec la logistique et ses opérations.

Défi

Une analyse à haut niveau du système de données utilisées par l’APL par les conseillers de Larochelle a permis de mettre en évidence différentes lacunes:

- La qualité des données

La qualité des données est impactée par différents éléments : duplication de données au sein de différentes instances, manque de clarté dans la définition et les exceptions de données, absence de données de référence, absence de la traçabilité des données, …

- Le cloisonnement des données:

Les données sont réparties au sein de deux systèmes ERP (Enterprise Resource Planning) indépendants sur site. L’un correspond à l’ERP alimenté par le centre de répartition de l’APL. L’autre est l’ancien ERP dont les données n’ont pas été migrées.

- Le manque de flexibilité dans la gestion des données:

L’intégration de nouvelles sources de données n’est pas envisageable avec le système de données en place. Tout comme l’est l’ajout de nouveaux types de données telles que les définitions des différentes saisons de service et de facturation ou encore le regroupement de types de charges.

- L’accessibilité des données:

La personne en charge des analyses chez l’APL ne dispose pas d’accès direct aux données. De plus, cette personne ne possède pas les connaissances techniques nécessaires ni d’outil de reporting. Elle n’est donc pas en mesure de produire elle-même ses rapports d’analyse.

- La fiabilité des rapports d’analyse:

Le risque d’erreur humaine impacte lourdement la fiabilité des rapports puisque ces derniers sont montés manuellement à travers divers fichiers Excel.

- Le délai d’obtention des rapports d’analyse :

Bien que déjà impacté par la dépendance à leur fournisseur, le délai d’obtention des rapports est alourdi par leur délai d’exécution.

- Le coût de production des rapports:

Étant donné les solutions disponibles sur le marché, les coûts de production de rapports de l’APL ne sont pas justifiés.

Il va sans dire que ces éléments nuisent drastiquement aux possibilités d’analyses de l’APL qui souhaite y remédier par un système d’intelligence de marché lui permettant de créer elle-même ses rapports ad hoc, des tableaux de bord et d’établir ses KPI.

Solution

Une des premiers éléments à adresser concerne l’hébergement du nouvel écosystème de données à créer. L’APL ne souhaite pas héberger leur future solution BI sur leur serveur applicatif. Elle n’envisage pas non plus ajouter un serveur sur site à cause du manque de main d’œuvre qualifiée pour l’entretenir. C’est pourquoi les conseillers de Larochelle lui proposent la mise en place d’une plateforme de données infonuagique. Comme l’APL utilise déjà Microsoft, c’est Azure qui est retenu pour héberger le nouvel écosystème de données à créer.

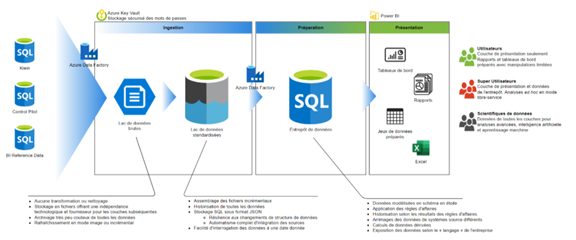

Comme l’illustre le schéma ci-dessous, l’écosystème se compose d’un lac de données et d’un entrepôt de données avec des tables structurées selon les principes de modèle en étoile.

Les sources de données correspondent à celle de l’ERP utilisé ainsi qu’à la base de données de l’ancien ERP. Pour intégrer ces données, Azure Data Factory est utilisé pour construire les pipelines d’extraction-chargement-transformation, soit le processus ELT. Soit l’extraction et le chargement des données pour les amener au lac de données et la transformation pour l’entrepôt de données.

L’intégration des données se fera selon une fréquence établie par l’organisation de manière automatisée, afin de garantir la fiabilité de l’information délivrée.

Pour l’exécution des analyses de données, c’est Power BI qui est retenue et permet :

- La création d’un modèle de données.

- La création de rapports.

- La création de jeux de données préparés.

- La création de tableaux de bord.

- La création de requêtes ad hoc.

- L’exploration des données sources.

Un volet de formation est prévu au mandat et comprend l’accompagnement de l’administrateur de système ainsi qu’un transfert de connaissance sur l’utilisation des modèles analytiques. Nos conseillers s’assurent ainsi de la pleine autonomie de son client dans l’administration et l’utilisation de sa solution BI.

La plateforme de données est maintenant fonctionnelle depuis plusieurs mois. Notre client en est pleinement satisfait. C’est la fin de la navigation à vue et le début de prises de décision éclairées pour l’APL! Elle dispose d’un outil fiable qui répond entièrement aux besoins de ses utilisateurs, voire davantage. De l’information pertinente et juste peut être rapidement livrer à la direction de l’APL. Et, quand elle le souhaitera, l’APL aura la possibilité de faire évoluer sa solution avec d’autres axes d’analyses, de métriques et d’autres sujets de données.